Re: ChatGPT

Publié : 04 avr. 2023, 16:12

4.000.000 de tokens, c'est beaucoup. C'est ça que tu as payé je pense.

Oui, c'est ce que j'ai payé, mais ma question c'est: comment un texte de 4400 caractères pourrait-il générer 4,000,000 de tokens ?thewild a écrit : 04 avr. 2023, 16:12 4.000.000 de tokens, c'est beaucoup. C'est ça que tu as payé je pense.

Salut Invité,Invité a écrit : 04 avr. 2023, 15:07 Salut Dash.

Mon expérience avec Llama a été coûteuse [...] [...]

En effet, je comprends. Moi aussi j'hésite. Mais ce qui se passe est passionnant...Invité a écrit :...qui me semble quand même un peu limité.

Le chabot aurait-il tendance à conforter son interlocuteur plutôt qu'à le dissuader ?MaisBienSur a écrit : 05 avr. 2023, 10:35 -----------------------

Je ne jugerais pas comme coupable l'IA ici, on peut imaginer facilement que des problèmes plus profonds et/ou anciens sont à l'origine du mal être de cette personne et donc de son suicide, mais on voit les limites de la conversation avec un "robot" en opposition avec l'humain (même si certains ont déjà pousser d'autres personnes à mettre fin à leurs jours).

Plaire, je ne pense pas, mais être "direct" donc parler sans fioritures dans certaines circonstances peut être néfaste pour un être fragilisé.jean7 a écrit : 05 avr. 2023, 11:35 Le chabot aurait-il tendance à conforter son interlocuteur plutôt qu'à le dissuader ?

Il est peut-être programmé pour aider, satisfaire, plaire ...

?

Techniquement, je ne le jugerai pas coupable, et ce, dans tous les cas. Mais je comprends ce que tu veux dire.

chatGPT n'a pas d'intention. Oui, nous pouvons ajouter des poids à certains paramètres, une forme de biais IA. Mais ça peut aller dans tous les sens. C'est très problématique. D'ailleurs plusieurs scientifiques de l'IA, des gouvernements, veulent encadrer et légiférer l'IA et même imposer un moratoire.jean7 a écrit : 05 avr. 2023, 11:35Le chabot aurait-il tendance à conforter son interlocuteur plutôt qu'à le dissuader ?MaisBienSur a écrit : 05 avr. 2023, 10:35 -----------------------

Je ne jugerais pas comme coupable l'IA ici, on peut imaginer facilement que des problèmes plus profonds et/ou anciens sont à l'origine du mal être de cette personne et donc de son suicide, mais on voit les limites de la conversation avec un "robot" en opposition avec l'humain (même si certains ont déjà pousser d'autres personnes à mettre fin à leurs jours).

Il est peut-être programmé pour aider, satisfaire, plaire ...

?

Abonder dans le sens le plus probable. C'est un peu un problème.MaisBienSur a écrit : 05 avr. 2023, 13:49 Pour prendre un cas plus terre a terre, un interlocuteur se renseignant sur son cancer en phase terminal ne devrait pas s'attendre à une réponse du style: "soyez confiant, tant que vous êtes vivant, tout est possible". Une IA devrait abonder dans le sens d'une probabilité élevée de mort là où un ami essayerait surtout de vous faire espérer, quitte à mentir.

Que croyez-vous ferons les Bing, Google, Apple, Facebook, Twitter, TikTok, WhatsApp... avec ça?Cependant, le programme informatique est aussi capable de fournir des réponses et des solutions prometteuses à des problèmes beaucoup plus personnels, comme des questions sur des soucis de santé.

Dans la plus récente politique de confidentialité d’OpenAI, on peut lire : « Lorsque vous utilisez nos Services, nous pouvons collecter des informations personnelles qui sont incluses dans les entrées, les téléchargements de fichiers ou les commentaires que vous fournissez à nos Services [“Contenu”] ».

L’entreprise indique également que « dans certaines circonstances, [elle peut] fournir vos informations personnelles à des tiers sans préavis, sauf si la loi l’exige ».

https://www.ledevoir.com/societe/787321 ... oite_extra

Willison propose de bonnes instructions étape par étape pour tous ceux qui voudraient s'y essayer.Les choses évoluent à la vitesse de l'éclair au pays de l'IA. Vendredi, un développeur de logiciels nommé Georgi Gerganov a créé un outil appelé "llama.cpp" qui permet d'exécuter localement sur un ordinateur portable Mac le nouveau modèle de grand langage d'IA de classe GPT-3 de Meta, LLaMA. Peu de temps après, des personnes ont découvert comment faire fonctionner LLaMA sous Windows également. Ensuite, quelqu'un a montré qu'il fonctionnait sur un téléphone Pixel 6, puis sur un Raspberry Pi (bien qu'il fonctionne très lentement).

Things are moving at lightning speed in AI Land. On Friday, a software developer named Georgi Gerganov created a tool called "llama.cpp" that can run Meta's new GPT-3-class AI large language model, LLaMA, locally on a Mac laptop. Soon thereafter, people worked out how to run LLaMA on Windows as well. Then someone showed it running on a Pixel 6 phone, and next came a Raspberry Pi (albeit running very slowly).

https://arstechnica.com/information-tec ... pberry-pi/

Comme l'auteur le signal, avec un peu de connaissance informatique, n'importe qui pourra exécuté une version de LLaMA. Avant cela, il existait une mince couche de défense, des entreprises comme OpenAI ayant une capacité limitée à contrôler la manière dont les gens interagissaient avec ces modèles. Maintenant que nous pouvons faire fonctionner ces modèles sur notre propre matériel, même ces contrôles ont disparu.Même si vous pouviez obtenir le modèle GPT-3, vous ne seriez pas en mesure de l'exécuter sur du matériel de base - ces choses nécessitent généralement plusieurs GPU de classe A100, dont chacun se vend au détail à plus de 8 000 dollars.

Even if you could obtain the GPT-3 model you would not be able to run it on commodity hardware—these things usually require several A100-class GPUs, each of which retail for $8,000+.

https://simonwillison.net/2023/Mar/11/llama/

Ça ne fait que commencer. Le problème, c'est ce que cette fausse information pourra être copier et coller tellement de fois que chatGPT repondra toujours la même fausseté.Un maire australien prévoit entamer une poursuite en diffamation contre ChatGPT si la compagnie OpenAI ne rectifie pas le tir après que le logiciel lui ait inventé un faux passé criminel et du temps derrière les barreaux pour corruption.

https://www.journaldemontreal.com/2023/ ... a-un-maire

En réponse à une question sur des articles sur ce sujet, l’IA en avait simplement inventé. Sa fluidité et les vastes données d’entraînement sur lesquelles elle est construite signifiaient que l’existence de la pièce inventée semblait même crédible à la personne qui ne l’avait absolument pas écrite. Heureusement, le chercheur nous avait dit qu’ils avaient effectué leurs recherches en utilisant ChatGPT.

Il y a deux jours, notre équipe des archives a été contactée par un étudiant qui lui a posé des questions sur un autre article manquant d’un journaliste nommé. Encore une fois, il n’y avait aucune trace de l’article dans nos systèmes. La source ? ChatGPT.

https://www.theguardian.com/commentisfr ... hdcijrRKco

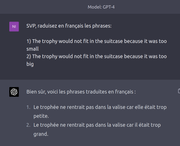

En passant, ceux qui croiraient qu'il ne fait que régurgiter un exemple qu'il a vu sur Internet, peuvent remplacer les objets (trophy par cat et suitcase par cage) et obtenir un résultat également correct.Si vous ne voyez pas l'image a écrit : Q: SVP, traduisez en français les phrases:

1) The trophy would not fit in the suitcase because it was too small

2) The trophy would not fit in the suitcase because it was too big

GPT-4:

Bien sûr, voici les phrases traduites en français :

Le trophée ne rentrait pas dans la valise car elle était trop petite.

Le trophée ne rentrait pas dans la valise car il était trop grand.

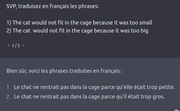

GPT-3.5 me de donne aussi la bonne traduction.Invité a écrit : 10 avr. 2023, 18:03 Voici un exemple qui montre que GPT-4 comprend le contexte d'un texte soumis pour une traduction.

Oui, parfois il donne la bonne, mais pas toujours.

I.Q: Traduire ces deux phrases:

The trophy would not fit in the suitcase because it was too small

The trophy would not fit in the suitcase because it was too big

ChatGPT3.5:

La première phrase signifie que le trophée ne rentrait pas dans la valise parce qu'il était trop grand, alors que la seconde phrase signifie que le trophée ne rentrait pas dans la valise parce qu'il était trop grand.

Voici les traductions en français:

Le trophée ne rentrait pas dans la valise car il était trop grand.

Le trophée ne rentrait pas dans la valise car il était trop petit.

https://www.lapresse.ca/affaires/2023-0 ... ilites.phpOttawa) Après avoir réclamé une pause de six mois dans la recherche sur l’intelligence artificielle (IA), il y a deux semaines, le scientifique Yoshua Bengio presse les législateurs canadiens de prendre leurs responsabilités en adoptant, dans les plus brefs délais, le projet de loi C-27 qui vise à réglementer le développement de cette technologie aux multiples possibilités.