Bonsoir à tous,

Voici donc le second épisode de mes délire "Weirdique" sur l'analyse de données ... et les moment où celle-ci vous fait peur.

Ce soir, nous allons parler de stacking ... pour les non-anglophone, nous allons empiler des choses !

Dans certains cas, quand vous étudié un phénomène, votre "signal sur bruit" (le rapport entre la valeur que vous voulez mesurer et l'incertitude associée) est faible au cas par cas.

Il peut alors devenir intéressant d'empiler plein d'observables pour "augmenter" ce signal sur bruit.

Intuitif me direz vous ? Oui en effet, cependant comme toujours vaut faire gaffe à ce que l'on fait

.

Revenons un peu dans le passé ... il y a de cela houlala pas loin de 4 ans maintenant ... j'essayais de mettre en évidence l'effet ISW sur le CMB

Qu'est-ce que cet effet bizarre ? Et c'est quoi le CMB d'abors ? ... Et non ce n'est pas Crédit Mutuel de Bretagne (désolé les fans de Google) !

Le CMB c'est ça :

http://fr.wikipedia.org/wiki/Fond_diffus_cosmologique

C'est le plus vieux rayonnement de l'Univers qu'il nous ais possible de mesurer, il as été émit au moment où l'Univers est devenu assez froid pour que les premiers noyaux atomique capture les électrons libres, qui jusque là empêchait les photons de se balader tranquillement tous seul.

L'ISW c'est ça :

http://fr.wikipedia.org/wiki/Effet_Sach ... A9gr%C3%A9

C'est un effet qui intervient quand les puits de potentiel gravitationnel varient au cours du temps. Ainsi si vous étiez un photons, et que vous descendiez dans un puits de potentiel, vous gagneriez de l'énergie, mais pour sortir il faudrait rendre cette énergie. Hors si l'amplitude du puits de potentiel varie au cours du temps, le bilan énergétique entre l'entrée dans le puits et la sortie (qui ne se passe pas au même instant "t") n'est pas nulle ... l'énergie du photons à donc changée ...

Comment on détecte ça ?

L'effet est faible, impossible à voir au cas par cas ... on va donc empiler. L'idée c'est que cette effet est corrélé avec la distribution de matière (potentiel gravitationnel) ... donc une approche possible est d’empiler les régions du ciel où il y a une forte densité de matière, pour amplifier l'effet et le détecter.

Bon, après cette bref séquence culture revenons à nos moutons ... empilons des choses ! Ici la carte du CMB, celle-ci plus précisément:

http://www.astro.rug.nl/~hidding/ao/wmap_groot.png

Comment on fait pour empiler des cartes.

Et bien on choisit les pixels que l'on veut empiler, ensuite on fait tourner la carte pour amener successivement chaque pixels au centre. Puis l'on sommes successivement chacune des cartes tournées. On effectue la somme sur l'ensemble du ciel et pas uniquement le pixel central car on s'intéresse à un signal étendu.

Ici j'ai refait l'exercice, mais en empilant des positions aléatoires (donc apriori après un grand nombre de carte empilées on s'attendrait à naïvement tendre vers une carte isotrope de valeur la moyenne de la carte initiale ... que néni, let's see).

Me direz vous, que peut-il bien arriver ?

Au début pas grand chose ... mais après avoir tourné puis empilés un bon millier de cartes on vois ceci apparaitre sous nos yeux:

http://img15.hostingpics.net/pics/901489cmbstack.png

cmb_stack.png

A partir de là deux réaction sont possible:

1) La réaction zozos, où encore la réaction Bogdanoff: "Oh my god, j'ai trouvé le visage de Dieu".

Bah oui voyons, on voit clairement les yeux (en rouge), le nez, les cheveux (en rouge aussi). Je peut même vous dire qu'il as l'air bien fatiguer ... regardez un peu ces grosses cernes bleu sous ces yeux

.

2) La réaction normal : WTF ....

bah voui comment ce faisse ... j'ai sommé des positions aléatoires ... y a absolument aucune raison de voir un signal cohérent apparaitre ...

Explications:

En effet en stackant des positions aléatoires, il n'y a aucune raison qu'un signal cohérent apparaissent, si vous êtes sur un plan ...

Mais le ciel n'est pas un plan, c'est une foutu surface de sphère. Et une surface de sphère ça des propriété de symétrie un peu chiantes

Une surface de sphère peut ce décomposer sur une base d'harmonique sphériques:

http://fr.wikipedia.org/wiki/Harmonique_sph%C3%A9rique

C'est une base avec des symétries sympa ... chaque fonction de la base peut-être décrit par deux nombre : l et m

Étudions un peu les rotations que nous avons utilisez:

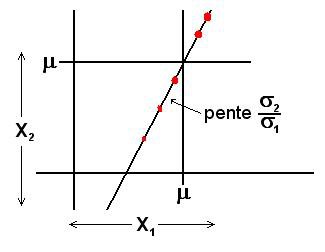

Ici j'ai utilisé 2 rotations (d’abords mettre la longitude à 0 (rotation d'axe z) puis mettre la latitude à 0 (rotation d'axe y)), si on le regarde comment ce comporte chaque harmonique sphérique celons ces rotations ont conclu que :

-Toutes les harmonique sphérique avec m ≠ 0 s'annule progressivement (si les pixels utilisez sont aléatoirement distribué sur le ciel de façon homogène)

-Toutes les harmonique avec m = 0 ne s'annule pas via ces rotations ... d'où notre soucis

.

Ce qui produit un effet systématique sur la carte final ...

Il est possible de faire l'inverse, annuler les m=0, mais dans ce cas se sont les m≠0 qui ne s'annule plus ... conduisant également à des systématiques (plus important, le nombre de modes m=0 étant plus petit que le nombre de modes m≠0).

Voici comment tout pennaux, ont peut faire apparaitre la "Face of God" à partir de n'importe quel carte du ciel (on pourrait aussi avec une carte complètement random) ... Juste en ne faisant pas attention à ce que l'on fait.

Vous avez déjà lu des papiers qui parle de stacking sur le ciel ? ... il ne parle pas de cet effets ? Normal, la plupart ignore qu'il existe, et qu'il faut soit débiaisé le stacking final de cette effet (mais c'est long), soit faire tourner les différentes harmonique sphériques selon deux type de rotations différentes (seulement valable si votre signal est à symétrie sphérique).

Quel sont les rotations à appliquer :

-m≠0 : successivement, rotation d'axe z (angle=-longitude), rotation d'axe y (angle=-colatitude), rotation d'axe x (angle=0)

-m=0 : successivement, rotation d'axe z (angle=-longitude), rotation d'axe y (angle=-colatitude), rotation d'axe x (angle=longitude)

Ca fait mal à la tête hein ? Mais au moins, les images sont jolies

.

Ah une prochaine fois pour une nouvelle "weirdité" ...

Vous ne pouvez pas consulter les pièces jointes insérées à ce message.